Le cas curieux de l'IA écrivant un opéra

"Laissez-moi vous raconter la fois où Claude m'a écrit tout un livret d'opéra..."

C'est ainsi que j'ai choisi d'introduire cette série dans l'article 1, en racontant l'histoire curieuse de ma demande concernant un "opéra écrit par une IA", qui s'est soldée par la livraison par Claude d'un script d'opéra original en cinq actes et plusieurs pages.

Je n'en revenais pas. Comment Claude a-t-il pu construire un arc narratif cohérent, des plaisanteries pleines d'esprit entre les sopranos et les ténors, et des chansons ponctuées d'émotions, tout cela à partir de ma réflexion "Je me demande à quoi ressemblerait un opéra écrit par Claude" ?

Claude a utilisé tout le contexte de ma demande - y compris les implications de mots comme "opéra", "cinq actes", "duos", "chansons" - pour manifester de manière appropriée une réponse sur mesure. Cette histoire illustre comment la compréhension du contexte est au cœur des capacités de communication de l'IA. Claude a analysé le cadre linguistique et situationnel que j'ai transmis par le biais du sous-texte, de la terminologie et de l'invitation à être créatif.

Dans cet article, nous allons explorer exactement comment le contexte façonne la capacité phénoménale des grands modèles de langage à générer de la parole. Comment la méthodologie de formation inculque-t-elle la sensibilité au contexte à des LLM tels que Claude ou ChatGPT ? Pourquoi l'ambiguïté fait-elle obstacle à ces modèles, et quels sont les progrès réalisés ? La compréhension du contexte reste la clé pour libérer le potentiel de l'IA tout en évitant les pièges de l'interprétation erronée.

Comment le contexte façonne la génération du langage

La génération de langage naturel est la capacité la plus visible des grands modèles de langage. À partir d'une invite textuelle, les modèles de langage peuvent générer des réponses cohérentes de plusieurs paragraphes adaptées à l'actualité et aux indices contextuels de l'invite. Les modèles modernes s'approchent de la capacité de conversation dans certains domaines en générant un langage de plus en plus pertinent et nuancé au fur et à mesure que les utilisateurs fournissent plus de contexte.

Comment les LLM acquièrent-ils cette capacité de génération contextuelle inégalée par les systèmes NLP précédents ? La réponse réside dans l'échelle et l'apprentissage auto-supervisé à partir de l'exposition à des ensembles de données textuelles massives. En ingérant plus d'un trillion de mots provenant de sources disparates, Claude et d'autres LLM apprennent des modèles statistiques sur la façon dont les mots se rapportent les uns aux autres en fonction des termes voisins. Cela permet la construction intuitive d'un langage qui reflète la séquence probable des mots compte tenu du contexte environnant.

Par exemple, Claude apprend à partir des données du Web que "chat" et "félin" sont plus étroitement associés à des mots comme "animal", "ronronner", "bondir" qu'à des termes sans rapport comme "ustensile" ou "hydrogène". Ainsi, lorsque je lui parle de "mon joli chat qui ronronne", Claude réagit en choisissant des mots pertinents.

Les grands ensembles de données permettent à Claude et à d'autres lambdas d'apprendre des régularités dans l'utilisation des mots en fonction du contexte sur des sujets tels que la politique, la science, le dialogue et bien d'autres. Claude apprend également des nuances plus subtiles, comme le fait que "pas bon" exprime la négativité, tandis que "pas mauvais" suggère la positivité. De telles inférences permettent de modeler le ton et le style de manière appropriée pour les tâches générationnelles.

Méthodologie de formation et sensibilité au contexte

Outre l'échelle, les progrès réalisés dans l'architecture des modèles et les techniques de formation améliorent également la gestion du contexte dans les LLM modernes. Des approches telles que la mémoire, l'attention éparse et le blocage contigu aident Claude à apprendre les relations entre des mots plus éloignés dans le texte. Cela permet d'améliorer la cohérence du discours dans la génération de formes longues.

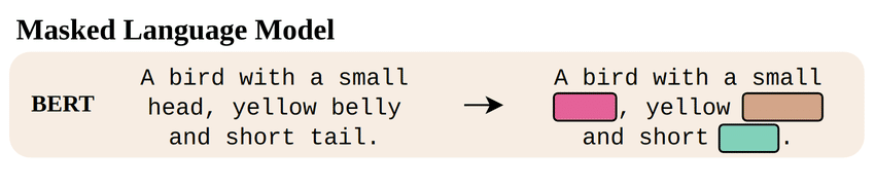

Les objectifs de pré-entraînement ont également évolué pour favoriser une meilleure contextualisation. Par exemple, certains modèles s'entraînent en prédisant les mots omis de manière aléatoire sur la base des termes environnants. L'estimation correcte des mots omis oblige à s'appuyer sur le contexte sémantique et syntaxique. D'autres astuces, telles que l'entraînement sur de longs passages de texte contigus, renforcent encore l'assimilation du contexte.

De nouvelles techniques permettent également de fournir aux LLMs un contexte externe à l'invite elle-même. Par exemple, la saisie explicite de connaissances sur le domaine de l'opéra avant de demander à Claude de générer un livret. Claude dispose ainsi d'un contexte thématique qui lui permet de générer des réponses plus appropriées. Nous explorerons ces techniques d'amorçage contextuel plus en détail dans la suite de cette série.

Mais tout d'abord, comment les LLM gèrent-ils les défis contextuels très nuancés tels que l'ambiguïté et le sous-texte ?

Ambiguïté, sous-texte et langage nuancé

Malgré les progrès réalisés, les grands modèles de langage ont encore du mal à traiter les phénomènes linguistiques très nuancés auxquels nous pouvons nous identifier en tant qu'êtres humains. Les doubles sens, les sarcasmes, les métaphores, l'ambiguïté - tout cela laisse l'IA dans l'expectative sans contexte suffisant. Claude peut exceller dans la conversation dans des domaines limités, mais il trébuche encore dans les dialogues complexes, chargés d'intentions.

Par exemple, Claude interprète la question "L'IA peut-elle être sarcastique ?" de façon littérale. Il répond en discutant sérieusement de l'incapacité de l'IA à transmettre des émotions complexes au-delà de la sincérité et du hasard. D'un autre côté, la plupart des gens en déduiraient mon sous-texte. La question "L'IA peut-elle être sarcastique ?" implique sarcastiquement une observation sur la capacité de Claude à reconnaître le sarcasme !

Ces bizarreries sont en partie dues à l'inadéquation entre les données d'entraînement de Claude et les contextes conversationnels du monde réel. Mais elles révèlent également des lacunes dans la capacité à désambiguïser les mots à sens multiples ou à résoudre les pronoms ambigus auxquels ils se réfèrent.

Les phrases ambiguës courantes font également trébucher les LLM, en fonction du contexte qui influence l'interprétation. Par exemple, le contexte expérientiel détermine si "fan flies around stadium" fait référence à un spectateur enthousiaste ou à un dispositif mécanique !

Sans un contexte bien ancré, le texte généré risque d'être inexact ou dépourvu de sens. L'accès à l'historique du dialogue situé aide les humains à gérer les énoncés dépourvus de contexte explicite. Nous devons mieux équiper les LLM avec des capacités similaires, comme nous l'explorerons dans des articles ultérieurs.

Pour conclure, il est indéniablement impressionnant de constater les progrès réalisés par les LLMs grâce à l'augmentation de la taille des modèles et des données d'entraînement. Et des innovations passionnantes axées spécifiquement sur l'amélioration de l'utilisation du contexte par les LLMs sont juste à l'horizon...

Mais tout d'abord, comment le contexte dans tous les différents contenus de formation que Claude et d'autres LLM ingèrent affecte-t-il exactement leur compréhension ? Nous y reviendrons dans l'article 3 !

Glossaire

- Génération de langage : La capacité des LLM à produire des continuations de texte originales et cohérentes en fonction d'une invite, d'une requête ou d'un exemple de l'utilisateur.

- Apprentissage auto-supervisé : Une approche de formation où les LLM apprennent en prédisant les mots masqués ou manquants dans les passages en fonction du contexte environnant.

- masked_models.

source : https://www.researchgate.net/figure/Self-supervised-language-and-vision-models-learn-representations-by-imputing-data_fig1_358259713

Cohérence du discours : Lorsque les LLM peuvent relier des concepts et maintenir un flux logique dans un texte long comportant plusieurs phrases ou paragraphes. - Objectifs de préformation : Tâches spécialisées utilisées pour former les LLM, comme la prédiction de mots masqués et la prédiction de la phrase suivante, destinées à enseigner des capacités linguistiques utiles.

- Contexte externe : Contexte supplémentaire au-delà de l'invite elle-même fourni explicitement au LLM, comme la connaissance d'un domaine pertinent sur un sujet, pour aider à la génération.

- Ambiguïté : Lorsque le langage a plusieurs significations potentielles qui dépendent fortement du contexte pour désambiguïser l'interprétation voulue.

Sous-texte : Idées, émotions ou intentions sous-jacentes implicites dans les déclarations explicites. Les sarcasmes, les métaphores et les doubles sens sont des exemples de sous-texte que les LLM ont actuellement du mal à percevoir. - La mise en place : L'intégration du contexte dans le raisonnement des LLM, comme les connaissances de base pertinentes sur les entités nommées et l'historique du discours, afin de réduire l'ambiguïté et d'améliorer la pertinence.